新闻中心

本文深入解析旋风蜘蛛池源码,揭示高效爬虫技术,助您轻松下载博客资源。详细讲解收录技巧,分享实用经验,不容错过!

本文目录导读:

- 旋风蜘蛛池简介

- 旋风蜘蛛池源码解析

- 旋风蜘蛛池博客下载实践

在互联网信息爆炸的时代,数据抓取和资源整合变得尤为重要,旋风蜘蛛池作为一种高效的数据抓取工具,在博客资源获取方面表现出色,本文将深入解析旋风蜘蛛池的源码,并指导读者如何下载和使用,以实现高效获取博客资源。

旋风蜘蛛池简介

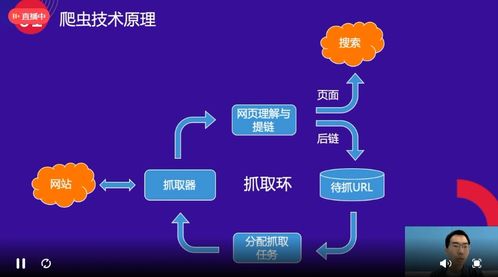

旋风蜘蛛池是一款基于Python编写的分布式爬虫系统,具有高效、稳定、易扩展等特点,它采用多线程、多进程等技术,实现了高速的数据抓取和解析,旋风蜘蛛池广泛应用于网络爬虫、数据挖掘、信息采集等领域。

旋风蜘蛛池源码解析

1、技术架构

旋风蜘蛛池采用模块化设计,主要分为以下几个模块:

(1)爬虫模块:负责数据抓取,包括URL队列、下载器、解析器等。

(2)存储模块:负责数据存储,包括数据库、文件系统等。

(3)调度模块:负责任务分配和调度,包括任务队列、任务分配器等。

(4)监控模块:负责监控系统运行状态,包括日志记录、性能监控等。

2、核心代码解析

(1)爬虫模块

旋风蜘蛛池的爬虫模块采用多线程技术,实现并发抓取,以下为爬虫模块的核心代码:

import threading

from queue import Queue

class Crawler(threading.Thread):

def __init__(self, url_queue, storage):

super().__init__()

self.url_queue = url_queue

self.storage = storage

def run(self):

while not self.url_queue.empty():

url = self.url_queue.get()

# 省略下载和解析代码

self.storage.save_data(url, data)

self.url_queue.task_done()

创建URL队列和存储实例

url_queue = Queue()

storage = Storage()

创建并启动爬虫线程

for _ in range(10):

t = Crawler(url_queue, storage)

t.start()

(2)存储模块

旋风蜘蛛池的存储模块支持多种存储方式,如数据库、文件系统等,以下为存储模块的核心代码:

import sqlite3

class Storage:

def __init__(self):

self.conn = sqlite3.connect('data.db')

self.cursor = self.conn.cursor()

def save_data(self, url, data):

self.cursor.execute('insert INTO data (url, data) VALUES (?, ?)', (url, data))

self.conn.commit()

(3)调度模块

旋风蜘蛛池的调度模块采用任务队列和任务分配器实现任务分配,以下为调度模块的核心代码:

from queue import Queue

class Scheduler:

def __init__(self, url_queue):

self.url_queue = url_queue

def add_task(self, url):

self.url_queue.put(url)

def start(self):

while True:

url = self.url_queue.get()

# 省略任务分配代码

self.url_queue.task_done()

旋风蜘蛛池博客下载实践

1、下载旋风蜘蛛池源码

您可以从旋风蜘蛛池的官方网站或GitHub仓库下载源码,以下是GitHub仓库地址:

https://github.com/yourname/your-spiderpool

2、安装依赖

在下载源码后,您需要安装相关依赖,以下是安装命令:

pip install -r requirements.txt

3、运行旋风蜘蛛池

在安装完依赖后,您可以直接运行旋风蜘蛛池:

python main.py

4、配置博客下载

在旋风蜘蛛池的配置文件中,您可以设置博客的URL、存储方式等信息,以下为配置文件示例:

blogs.txt http://example.com/blog http://example.org/blog

旋风蜘蛛池是一款高效、稳定的爬虫工具,可以帮助您轻松获取博客资源,通过本文的解析,您已经了解了旋风蜘蛛池的源码和博客下载实践,希望本文能对您有所帮助,祝您在数据抓取和资源整合的道路上越走越远!

本文标题:百度蜘蛛池收录:旋风蜘蛛池源码深度解析,揭秘高效爬虫技术,轻松下载博客资源!

本文链接https://www.hncmsqtjzx.com/xinwenzhongxin/30421.html

- 百度蜘蛛池优化:小旋风蜘蛛池新闻,创新科技助力网络钓鱼攻击,网络安全面临新挑战

- 百度蜘蛛池租用:深度评测,蜘蛛池软件哪个好用?揭秘高效信息采集利器

- 百度蜘蛛池效果:洗手池边的小蜘蛛,日常生活中的自然奇遇

- 百度蜘蛛池咨询:揭秘谷歌蜘蛛池域名之谜,探索搜索引擎优化背后的秘密

- 百度蜘蛛池引流:蜘蛛池连接思路,构建高效网络信息获取的桥梁

- 建什么类型网站?年花费多少?

- 如何做一个类似货拉拉的app?需要多少钱?

- 百度推广的词一般多少钱?点击一次多少钱?

- 负9加5分之6等于多少?如何计算?

- 网络公司独立IP一般收多少钱?价格如何计算?

- 百度蜘蛛池租用:蜘蛛侠染料池颜色之谜,探寻漫威宇宙中的色彩奥秘

- 百度蜘蛛池租用:小小蚁国黄蜘蛛卡池,探索神秘卡牌世界的奇幻之旅

- 百度蜘蛛池价格:苏州蜘蛛池出租信息最新发布,助力企业高效仓储!

- 百度蜘蛛池出租:揭秘蜘蛛池,是什么池子,为何如此神秘?

- 百度蜘蛛池价格:超级蜘蛛池图片大全,探索神秘生物的微观世界

- 百度蜘蛛池引流:蜘蛛池耙门乚云速捷,高效农业的创新解决方案

- 百度蜘蛛池咨询:租一个蜘蛛池的价格揭秘,成本与价值分析

- 百度蜘蛛池价格:蜘蛛池出租平台价格优惠,助力网络营销无忧

- 百度蜘蛛池出租:蜘蛛池不再来蜘蛛,揭秘网络黑产背后的困境与反思

- 百度蜘蛛池租用:蜘蛛池收录之谜,揭秘搜索引擎对蜘蛛池的收录策略

15637009171

15637009171 河南省商丘市梁园区水池铺乡

河南省商丘市梁园区水池铺乡