新闻中心

本文目录导读:

- 蜘蛛池简介

- 蜘蛛池源码解析

- 蜘蛛池搭建教程

随着互联网的快速发展,数据获取变得越来越重要,作为数据获取的重要手段,爬虫技术得到了广泛应用,而蜘蛛池作为一种高效、稳定的爬虫工具,受到了广大开发者的青睐,本文将为大家详细介绍蜘蛛池的源码及搭建教程,助你轻松掌握高效爬虫技术。

蜘蛛池简介

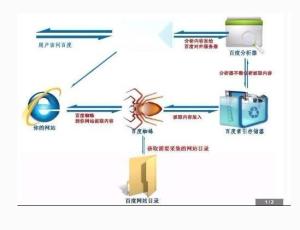

蜘蛛池,顾名思义,就是由多个爬虫组成的“蜘蛛网络”,通过搭建蜘蛛池,可以同时爬取多个网站,提高数据获取的效率,蜘蛛池通常由以下几个部分组成:

1、爬虫节点:负责从目标网站抓取数据。

2、数据存储节点:负责存储爬取到的数据。

3、数据处理节点:负责对爬取到的数据进行处理、清洗等操作。

4、控制节点:负责协调各个节点的工作,包括任务分配、节点管理等。

蜘蛛池源码解析

1、爬虫节点源码解析

爬虫节点通常采用Python编写,以下是一个简单的爬虫节点源码示例:

import requests

from bs4 import BeautifulSoup

def crawl(url):

try:

response = requests.get(url)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# 解析网页,提取数据

# ...

return soup

except Exception as e:

print(e)

if __name__ == '__main__':

url = 'http://www.example.com'

crawl(url)

2、数据存储节点源码解析

数据存储节点可以采用MySQL、MongoDB等数据库进行数据存储,以下是一个简单的MySQL存储节点源码示例:

import pymysql

def save_data(data):

try:

conn = pymysql.connect(host='localhost', user='root', password='123456', db='test')

cursor = conn.cursor()

cursor.execute("INSERT INTO data (title, content) VALUES (%s, %s)", (data['title'], data['content']))

conn.commit()

except Exception as e:

print(e)

finally:

conn.close()

if __name__ == '__main__':

data = {'title': '标题', 'content': '内容'}

save_data(data)

3、数据处理节点源码解析

数据处理节点主要负责对爬取到的数据进行处理、清洗等操作,以下是一个简单的数据处理节点源码示例:

def process_data(data):

# 数据处理逻辑

# ...

return data

if __name__ == '__main__':

data = {'title': '标题', 'content': '内容'}

processed_data = process_data(data)

print(processed_data)

4、控制节点源码解析

控制节点主要负责协调各个节点的工作,包括任务分配、节点管理等,以下是一个简单的控制节点源码示例:

def distribute_task(task):

# 任务分配逻辑

# ...

pass

if __name__ == '__main__':

task = 'http://www.example.com'

distribute_task(task)

蜘蛛池搭建教程

1、环境准备

确保你的电脑已经安装了Python、MySQL等必要的软件,以下是安装步骤:

(1)安装Python:前往Python官网下载Python安装包,按照提示进行安装。

(2)安装MySQL:前往MySQL官网下载MySQL安装包,按照提示进行安装。

2、编写源码

根据上述源码解析,编写各个节点的源码。

3、配置数据库

创建MySQL数据库,并创建数据表,用于存储爬取到的数据。

4、运行爬虫

运行爬虫节点源码,开始爬取数据。

5、数据存储与处理

爬取到的数据将自动存储到数据库中,同时可以通过数据处理节点对数据进行处理。

6、节点管理

通过控制节点,可以对各个节点进行管理,包括任务分配、节点状态监控等。

本文详细介绍了蜘蛛池的源码及搭建教程,帮助开发者轻松掌握高效爬虫技术,在实际应用中,可以根据需求对源码进行修改和优化,以提高爬虫效率,希望本文能对大家有所帮助。

本文标题:百度蜘蛛池出租:深度解析,蜘蛛池源码及搭建教程,助你轻松掌握高效爬虫技术

本文链接https://www.hncmsqtjzx.com/xinwenzhongxin/28832.html

- 百度蜘蛛池收录:如何自己搭建蜘蛛池,从零开始构建高效爬虫平台

- 百度蜘蛛池优化:揭秘蜘蛛池外链技术,网络SEO优化中的神秘力量

- 百度蜘蛛池收录:揭秘蜘蛛池免费超级蜘蛛,助力网站SEO优化新利器

- 百度蜘蛛池租用:揭秘蜘蛛池,什么是蜘蛛池,它有什么作用?

- 百度蜘蛛池效果:小霸王蜘蛛池源码免费下载,揭秘高效数据采集利器背后的奥秘

- 百度蜘蛛池收录:蜘蛛池搭建全攻略,原理图解+视频教程,轻松入门网络营销新利器!

- 百度蜘蛛池优化:小蜘蛛卢卡斯与他的洗脸池,一段温馨的家居生活记实

- 百度蜘蛛池租用:小蜘蛛学绝池讲话,探索语言魅力之旅

- 百度蜘蛛池收录:清风算法,揭秘官网蜘蛛池在搜索引擎优化中的应用与策略

- 百度蜘蛛池引流:麟池Fighting超凡蜘蛛侠,一场跨越次元的英雄对决

- 百度蜘蛛池咨询:土蜘蛛池暴击吗?揭秘这款游戏的独特魅力与技巧

- 百度蜘蛛池优化:蜘蛛池名词解读,揭秘网络营销中的神秘力量

- 百度蜘蛛池咨询:搭建蜘蛛池视频讲解教程,轻松实现高效内容抓取与网络信息收集

- 百度蜘蛛池租用:谷歌蜘蛛池官网下载,深度解析搜索引擎优化利器

- 百度蜘蛛池出租:厨房奇遇,蜘蛛在洗碗池巧妙结网

- 百度蜘蛛池咨询:百度搭建蜘蛛池教程图解,轻松掌握搜索引擎优化新技能

- 百度蜘蛛池优化:揭秘蜘蛛池容量,一般多大?如何优化?

- 百度蜘蛛池引流:滴滴友链蜘蛛池搜外问答,揭秘高效内容分发与SEO优化之道

- 百度蜘蛛池效果:揭秘百度SEO排名工具,外推蜘蛛池在优化策略中的关键作用

- 百度蜘蛛池租用:蜘蛛池管理系统APP,智能化网络营销利器,助力企业高效推广

15637009171

15637009171 河南省商丘市梁园区水池铺乡

河南省商丘市梁园区水池铺乡