新闻中心

百度蜘蛛池利用超级蜘蛛池程序高效采集网络数据,成为数据采集利器。其存在也带来挑战,如数据安全、滥用风险等问题需关注。

本文目录导读:

- 超级蜘蛛池程序概述

- 超级蜘蛛池程序的应用场景

- 超级蜘蛛池程序带来的挑战

随着互联网的飞速发展,数据已经成为新时代的重要资源,在众多数据采集工具中,超级蜘蛛池程序因其高效、强大的数据抓取能力而备受关注,本文将深入剖析超级蜘蛛池程序的工作原理、应用场景以及其带来的挑战。

超级蜘蛛池程序概述

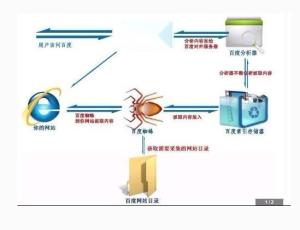

超级蜘蛛池程序,又称分布式爬虫,是一种基于多台服务器协同工作的网络数据采集工具,它通过模拟搜索引擎蜘蛛的行为,自动抓取网站内容,并将数据存储到数据库中,相较于传统的单机爬虫,超级蜘蛛池程序具有以下特点:

1、分布式架构:超级蜘蛛池程序将任务分配到多台服务器上,实现并行处理,提高数据采集效率。

2、高度自动化:程序可自动识别网站结构,根据设定的规则抓取数据,减少人工干预。

3、智能调度:程序可根据任务执行情况,动态调整爬虫数量和抓取策略,保证数据采集的稳定性。

4、数据存储:超级蜘蛛池程序可将采集到的数据存储到数据库中,方便后续处理和分析。

超级蜘蛛池程序的应用场景

1、竞品分析:企业可通过超级蜘蛛池程序,采集竞争对手的网站内容,分析其产品、服务、营销策略等,为自身业务提供参考。

2、数据挖掘:超级蜘蛛池程序可从海量网站中挖掘有价值的数据,为研究人员、学者提供数据支持。

3、信息监控:政府部门、企业等可利用超级蜘蛛池程序,对网络信息进行实时监控,确保网络安全。

聚合:超级蜘蛛池程序可将分散在各个网站上的信息进行整合,为用户提供一站式服务。

5、垂直领域应用:在金融、医疗、教育等垂直领域,超级蜘蛛池程序可帮助相关机构采集行业数据,助力业务发展。

超级蜘蛛池程序带来的挑战

1、数据安全:超级蜘蛛池程序在抓取数据过程中,可能涉及敏感信息,如用户隐私、商业机密等,如何确保数据安全,防止数据泄露,成为一大挑战。

2、法律风险:在抓取数据时,可能触及版权、隐私等法律问题,如何遵守相关法律法规,降低法律风险,是超级蜘蛛池程序面临的重要问题。

3、网站反爬策略:随着网站反爬策略的不断升级,超级蜘蛛池程序需要不断调整抓取策略,以应对网站的反爬措施。

4、数据质量:虽然超级蜘蛛池程序能高效采集数据,但采集到的数据质量参差不齐,如何提高数据质量,确保数据准确性,是超级蜘蛛池程序需要解决的问题。

超级蜘蛛池程序作为网络数据采集的利器,在众多领域发挥着重要作用,在享受其带来的便利的同时,我们也要关注其带来的挑战,努力提高数据安全、降低法律风险,确保数据质量,超级蜘蛛池程序才能在新时代发挥更大的价值。

本文标题:百度蜘蛛池效果:揭秘超级蜘蛛池程序,网络数据采集的利器与挑战

本文链接https://www.hncmsqtjzx.com/xinwenzhongxin/20975.html

- 百度蜘蛛池收录:湖北蜘蛛池租用服务,助力企业高效拓展网络营销新渠道

- 百度蜘蛛池价格:将蒙信息科技蜘蛛池,揭秘高效信息采集与处理的核心力量

- 百度蜘蛛池咨询:揭秘4蜘蛛池镜像站群,高效内容分发与SEO优化的秘密武器

- 百度蜘蛛池租用:不凡蜘蛛池,揭秘神奇生物的神秘家园

- 百度蜘蛛池咨询:蜘蛛池关键词优化,助力网站排名提升的利器

- 百度蜘蛛池引流:蜘蛛三池,揭秘神秘的网络空间生态

- 百度蜘蛛池引流:怎么建蜘蛛池教程,从零开始构建高效信息抓取平台

- 百度蜘蛛池效果:蜘蛛池爬虫,揭秘网络爬虫中的神秘力量

- 百度蜘蛛池效果:四川蜘蛛池出租,高效农业设施助力农产品品质提升

- 百度蜘蛛池收录:蜘蛛池搭建员竟化身氵云速捷,揭秘网络世界的隐秘力量

- 百度蜘蛛池咨询:战群养蜘蛛池,揭秘新型农业养殖模式

- 百度蜘蛛池咨询:蜘蛛池名词解读,高清图片带你走进网络世界的蜘蛛世界

- 百度蜘蛛池咨询:深入解析蜘蛛池技术,ZJKWLGS在互联网时代的应用与发展

- 百度蜘蛛池租用:猪八戒勇闯蜘蛛池,一场奇幻的视觉盛宴——揭秘猪八戒进蜘蛛池了吗视频背后的故事

- 百度蜘蛛池价格:自制蜘蛛池高清大全,打造居家生态观察新天地

- 百度蜘蛛池租用:蜘蛛池奇观,高清壁纸带你沉浸蜘蛛池游泳的独特魅力

- 百度蜘蛛池出租:蜘蛛评价小决池,一场别开生面的生态奇观

- 百度蜘蛛池出租:蜘蛛池配合泛目录,提升网站SEO效果的利器

- 百度蜘蛛池优化:蜘蛛侠逆袭!惊心动魄的大战死亡之池

- 百度蜘蛛池咨询:深度解析,如何搭建蜘蛛池,高效助力SEO优化

15637009171

15637009171 河南省商丘市梁园区水池铺乡

河南省商丘市梁园区水池铺乡