新闻中心

本文探讨了利用Golang编写高效爬虫,结合线程池优化百度蜘蛛池引流的方法。通过实践,实现了抓取速度的提升,为网站优化和SEO提供了有力支持。

本文目录导读:

- Golang爬虫概述

- 蜘蛛与线程池

- Golang爬虫线程池优化

随着互联网的快速发展,信息获取变得愈发便捷,在浩瀚的网络世界中,如何快速、高效地获取所需信息成为了一个难题,作为一款高性能的编程语言,Golang凭借其并发处理能力,在爬虫开发领域大放异彩,本文将结合Golang、蜘蛛和线程池,探讨如何优化爬虫抓取速度,实现高效的信息获取。

Golang爬虫概述

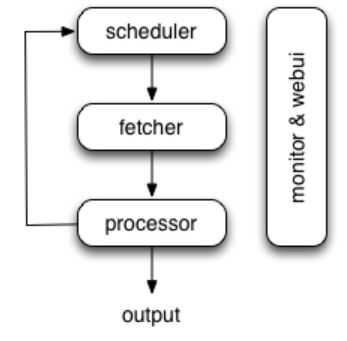

Golang(Go语言)是一种静态强类型、编译型、并发型编程语言,其简洁的语法、高效的并发处理能力,使得Golang在爬虫开发领域备受青睐,Golang爬虫主要包含以下功能:

1、网络请求:使用Golang内置的http包实现网络请求,获取网页内容。

2、数据解析:利用正则表达式、XPath、DOM等工具解析网页数据。

3、数据存储:将抓取到的数据存储到数据库、文件或其他存储介质。

4、链接抽取:根据需求,从网页中提取有效链接,实现深度爬取。

5、反爬虫处理:针对目标网站的反爬虫策略,采取相应的应对措施。

蜘蛛与线程池

1、蜘蛛

蜘蛛是爬虫程序的核心,负责遍历网页、提取链接、抓取数据,一个优秀的蜘蛛应具备以下特点:

(1)高效:能够快速遍历网页,提高抓取速度。

(2)精准:准确提取有效链接和数据,降低无效数据比例。

(3)稳定:在复杂网络环境下,保持稳定运行。

2、线程池

线程池是一种优化线程资源的方式,通过限制线程数量,提高程序执行效率,在Golang中,可以使用sync.Pool实现线程池。

(1)线程池优势

1)减少线程创建和销毁的开销。

2)提高程序并发处理能力。

3)降低线程竞争,提高程序稳定性。

(2)线程池实现

在Golang中,可以使用sync.Pool实现线程池,以下是一个简单的线程池实现示例:

type ThreadPool struct {

pool sync.Pool

size int

}

func NewThreadPool(size int) *ThreadPool {

pool := &ThreadPool{

pool: sync.Pool{

New: func() interface{} {

return new(Thread)

},

},

size: size,

}

return pool

}

func (t *ThreadPool) Run(task func()) {

t.pool.Put(&Thread{task: task})

if t.pool.Len() < t.size {

go func() {

for {

thread := t.pool.Get().(*Thread)

thread.task()

t.pool.Put(thread)

}

}()

}

}

type Thread struct {

task func()

}

Golang爬虫线程池优化

1、使用线程池

在Golang爬虫中,使用线程池可以显著提高抓取速度,以下是一个基于线程池的Golang爬虫示例:

func main() {

pool := NewThreadPool(10)

defer pool.Stop()

// 爬取目标网页

url := "http://example.com"

pool.Run(func() {

data, err := fetch(url)

if err != nil {

fmt.Println("Fetch error:", err)

return

}

// 解析数据

parse(data)

})

}

func fetch(url string) (string, error) {

resp, err := http.Get(url)

if err != nil {

return "", err

}

defer resp.Body.Close()

return ioutil.ReadAll(resp.Body)

}

func parse(data string) {

// 解析数据

fmt.Println("Parse data:", data)

}

2、链接抽取与深度控制

在爬虫中,合理地抽取链接并进行深度控制,可以降低无效数据比例,提高抓取效率,以下是一个基于深度控制的Golang爬虫示例:

func crawl(url string, depth int) {

if depth <= 0 {

return

}

data, err := fetch(url)

if err != nil {

fmt.Println("Fetch error:", err)

return

}

// 解析数据

links := extractLinks(data)

for _, link := range links {

crawl(link, depth-1)

}

}

func extractLinks(data string) []string {

// 提取链接

return []string{"http://example.com/1", "http://example.com/2"}

}

3、反爬虫处理

针对目标网站的反爬虫策略,可以采取以下措施:

(1)设置合理的User-Agent。

(2)使用代理IP。

(3)限制请求频率。

(4)采用分布式爬虫。

本文以Golang、蜘蛛和线程池为核心,探讨了如何优化爬虫抓取速度,通过使用线程池、链接抽取与深度控制、反爬虫处理等技术,可以提高Golang爬虫的效率,实现高效的信息获取,在实际应用中,可以根据具体需求对爬虫进行优化和调整,以满足不同的业务场景。

本文标题:百度蜘蛛池引流:Golang爬虫实践,高效利用线程池优化蜘蛛抓取速度

本文链接https://www.hncmsqtjzx.com/xinwenzhongxin/18575.html

- 百度蜘蛛池效果:蜘蛛池与外链的关系,揭秘搜索引擎优化中的关键要素

- 百度蜘蛛池租用:陕西蜘蛛池出租服务,助力企业高效数据采集,开启智能数据时代

- 百度蜘蛛池价格:揭秘养蜘蛛池,什么是养蜘蛛池及其重要性

- 百度蜘蛛池效果:探索外星人蜘蛛池.com,揭秘神秘网络世界的奥秘

- 百度蜘蛛池效果:绿蜘蛛池,自然与科技的完美融合

- 百度蜘蛛池收录:蜘蛛池搭建攻略,选大将军20,打造高效信息采集平台

- 百度蜘蛛池收录:蜘蛛矿池演化方案,区块链时代的矿池进化之路

- 百度蜘蛛池租用:野外生存必备技能,如何巧妙建造蜘蛛池,获取天然蛋白质来源

- 百度蜘蛛池租用:揭秘网络黑产,外链蜘蛛池与寄生虫的暗流涌动

- 百度蜘蛛池价格:揭秘蜘蛛池推送工具,助力内容分发,提升SEO效果的秘密武器

- 百度蜘蛛池出租:红蜘蛛池多肉,魅力无限的多肉植物组合与养护技巧

- 百度蜘蛛池价格:揭秘高酷蜘蛛池入口,网络世界的神秘力量

- 百度蜘蛛池收录:免费蜘蛛池网站下载安装指南,轻松搭建属于自己的数据采集平台

- 百度蜘蛛池引流:蜘蛛池租用价格解析,性价比与品质的完美结合

- 百度蜘蛛池引流:揭秘滴滴友链蜘蛛池,大数据时代的流量秘密武器

- 百度蜘蛛池优化:揭秘好用的百度蜘蛛池,助力网站优化,提升搜索引擎排名

- 百度蜘蛛池收录:蜘蛛池搭建教程,图片大全带你轻松入门网络爬虫世界

- 百度蜘蛛池引流:蜘蛛池菜青虫,绿色农业的守护者

- 百度蜘蛛池效果:蜘蛛池申请,揭秘高效网络营销的秘密武器

- 做一个app多少钱?影响因素有哪些?

15637009171

15637009171 河南省商丘市梁园区水池铺乡

河南省商丘市梁园区水池铺乡