新闻中心

创建高效蜘蛛池的关键在于优化网络爬虫的配置。选择合适的爬虫软件,如Scrapy,并合理设置爬取规则,避免违规行为。构建稳定的节点网络,确保数据传输效率。实施数据去重和清洗,提高数据质量。通过这些措施,蜘蛛池能成为网络爬虫的强大工具。

本文目录导读:

- 了解蜘蛛池

- 创建蜘蛛池的步骤

随着互联网的飞速发展,信息量的爆炸式增长,网络爬虫(也称为蜘蛛)在数据采集、搜索引擎优化、市场调研等领域发挥着越来越重要的作用,蜘蛛池作为网络爬虫的重要组成部分,其性能和效率直接影响着爬虫的工作效果,本文将详细介绍如何创建一个高效、稳定的蜘蛛池。

了解蜘蛛池

蜘蛛池,顾名思义,是指一个由多个网络爬虫组成的集群,这些爬虫协同工作,共同完成数据采集任务,一个高效的蜘蛛池能够提高爬虫的爬取速度、降低服务器负载、减少重复爬取,从而提高数据采集的准确性和效率。

创建蜘蛛池的步骤

1、确定爬虫类型

需要根据实际需求选择合适的爬虫类型,常见的爬虫类型包括通用爬虫、垂直爬虫、深度爬虫等,通用爬虫适用于广泛的数据采集,而垂直爬虫则针对特定领域进行数据采集,根据需求选择合适的爬虫类型,有助于提高蜘蛛池的效率。

2、编写爬虫代码

编写爬虫代码是创建蜘蛛池的关键步骤,以下是一个简单的Python爬虫代码示例:

import requests

from bs4 import BeautifulSoup

def crawl(url):

try:

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 解析网页内容,提取所需数据

# ...

except Exception as e:

print("Error:", e)

if __name__ == "__main__":

url_list = ["http://example.com/page1", "http://example.com/page2", ...]

for url in url_list:

crawl(url)

3、选择合适的爬虫框架

为了提高爬虫的效率,可以选择合适的爬虫框架,常见的爬虫框架有Scrapy、BeautifulSoup、Selenium等,Scrapy是一个强大的爬虫框架,具有高性能、易扩展等特点。

4、配置爬虫参数

在创建蜘蛛池时,需要配置以下参数:

(1)爬虫数量:根据服务器性能和任务需求,合理配置爬虫数量,过多会导致服务器负载过高,过少则影响爬取速度。

(2)下载延迟:设置爬虫下载延迟,避免短时间内大量请求导致服务器拒绝服务。

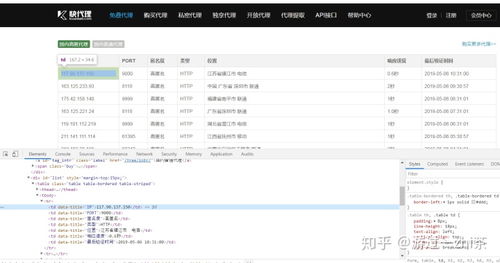

(3)代理IP:使用代理IP可以提高爬虫的隐蔽性,降低被封的风险。

5、部署爬虫

将爬虫代码部署到服务器,可以使用以下方法:

(1)使用Scrapy框架部署:将爬虫代码保存为Scrapy项目,然后在服务器上运行Scrapy命令进行部署。

(2)使用Docker容器部署:将爬虫代码打包成Docker镜像,然后在服务器上运行Docker容器进行部署。

6、监控与优化

在运行蜘蛛池的过程中,需要定期监控爬虫的运行状态,如爬取速度、数据质量等,根据监控结果,对爬虫代码、参数等进行优化,以提高蜘蛛池的效率。

创建一个高效、稳定的蜘蛛池需要综合考虑多个因素,包括爬虫类型、代码编写、框架选择、参数配置、部署与优化等,通过不断优化和调整,可以构建一个满足实际需求的蜘蛛池,为网络爬虫工作提供有力支持。

本文标题:百度蜘蛛池咨询:如何创建高效的蜘蛛池,网络爬虫的利器

本文链接https://www.hncmsqtjzx.com/xinwenzhongxin/16255.html

- 百度蜘蛛池收录:蜘蛛矿池演化方案,区块链时代的矿池进化之路

- 百度蜘蛛池租用:野外生存必备技能,如何巧妙建造蜘蛛池,获取天然蛋白质来源

- 百度蜘蛛池租用:揭秘网络黑产,外链蜘蛛池与寄生虫的暗流涌动

- 百度蜘蛛池价格:揭秘蜘蛛池推送工具,助力内容分发,提升SEO效果的秘密武器

- 百度蜘蛛池出租:红蜘蛛池多肉,魅力无限的多肉植物组合与养护技巧

- 百度蜘蛛池价格:揭秘高酷蜘蛛池入口,网络世界的神秘力量

- 百度蜘蛛池收录:免费蜘蛛池网站下载安装指南,轻松搭建属于自己的数据采集平台

- 百度蜘蛛池引流:蜘蛛池租用价格解析,性价比与品质的完美结合

- 百度蜘蛛池引流:揭秘滴滴友链蜘蛛池,大数据时代的流量秘密武器

- 百度蜘蛛池优化:揭秘好用的百度蜘蛛池,助力网站优化,提升搜索引擎排名

- 百度蜘蛛池收录:蜘蛛池搭建教程,图片大全带你轻松入门网络爬虫世界

- 百度蜘蛛池引流:蜘蛛池菜青虫,绿色农业的守护者

- 百度蜘蛛池效果:蜘蛛池申请,揭秘高效网络营销的秘密武器

- 做一个app多少钱?影响因素有哪些?

- 开发一个H5自适应网站多少钱?影响因素有哪些?

- 百度蜘蛛池租用:决池打蜘蛛,一场与自然的较量

- 百度蜘蛛池租用:链轮蜘蛛池,揭秘高效内容抓取的秘密武器

- 如何开发一个b2b平台?需要多少投资?

- 重庆渝北区开发蔬菜配送app多少钱?功能需求包括哪些?

- 三年级数学,甲厂有多少人?乙厂有多少人?

15637009171

15637009171 河南省商丘市梁园区水池铺乡

河南省商丘市梁园区水池铺乡